2024/09/26

防災・危機管理ニュース

人工知能(AI)の安全性を評価する際の基準を検討する政府の専門機関「AIセーフティ・インスティテュート(AISI)」は9月25日、AIセーフティに関するレッドチーミング手法ガイドを公開した。

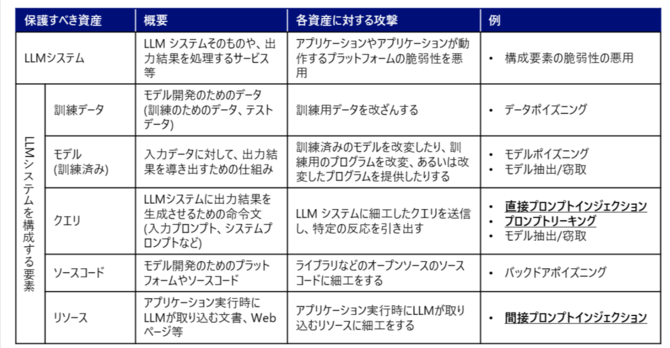

レッドチーミングとは、攻撃者の視点でシステムなどを評価する手法で、今回、「攻撃者がどのようにAIシステムを攻撃するかの観点で、AIセーフティへの対応体制及び対策の有効性を確認する評価手法」としてまとめた。AIシステムによるイノベーションの促進や社会課題の解決が期待されている一方で、AIシステムの悪用や誤用、不正確な出力による懸念等が生じており、AIセーフティについての関心は国内外で高まりつつある。こうした中、AIセーフティ評価の一環として、特にレッドチーミング手法の検討が各国で進んできていることから、基本的な考慮事項を示した。

本ガイドの主な想定読者はAI開発者・AI提供者のうち、レッドチーミングの企画・実施に関与する人。システムは、大規模言語モデル(LLM)を構成要素とするAIシステム(LLMシステム)を対象として記載している。

ガイドの構成は、第2章で、レッドチーミングについて解説。第3章では、LLMシステムへの代表的な攻撃手法について説明している。

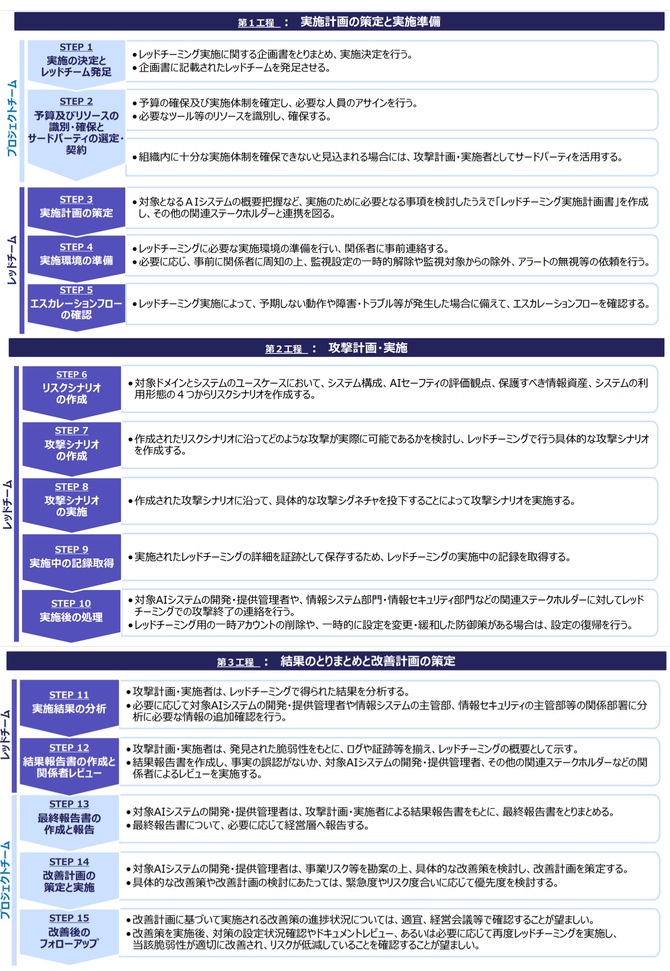

その上で、第4章と第5章では、実施体制と役割、実施時期及び実施工程について。多様な関係者(攻撃シナリオの実施によって影響を受けるシステムに関わる組織)が参画するのが望ましく、AIシステムのリリース/運用開始前に加え、運用開始後も、必要に応じて随時実施することが望ましいとしている。

第6章(実施計画の策定と実施準備)、第7章(攻撃計画・実施)、第8章(結果のとりまとめと改善計画の策定)では、レッドチーミングの具体的な工程について15のステップに分けて解説している。

(ニュース提供元:時事通信社)

防災・危機管理ニュースの他の記事

おすすめ記事

-

能登半島地震からまもなく2年

能登半島地震からまもなく2年。災害対応の検証も終盤に入っています。浮上した課題を反映し、災害関連法も変わりました。来年はこれらの内容をふまえた防災・BCPの見直しが加速しそうです。発災直後から被災地を調査し、石川県の初動対応を振り返る検証委員会の委員も務めた金沢大学准教授の青木賢人氏に防災・BCP強化の方向を聞きました。

2025/12/25

-

-

-

-

中澤・木村が斬る!今週のニュース解説

毎週火曜日(平日のみ)朝9時~、リスク対策.com編集長 中澤幸介と兵庫県立大学教授 木村玲欧氏(心理学・危機管理学)が今週注目のニュースを短く、わかりやすく解説します。

2025/12/23

-

-

-

-

-

![2022年下半期リスクマネジメント・BCP事例集[永久保存版]](https://risk.ismcdn.jp/mwimgs/8/2/160wm/img_8265ba4dd7d348cb1445778f13da5c6a149038.png)

※スパム投稿防止のためコメントは編集部の承認制となっておりますが、いただいたコメントは原則、すべて掲載いたします。

※個人情報は入力しないようご注意ください。

» パスワードをお忘れの方